الاتحاد الأوروبي يصدر قانون لتنظيم تطوير واستخدام الذكاء الاصطناعي

بعد الثورة التقنية المدوية التي شهدها مجال الذكاء الاصطناعي هذا العام، انتشرت المخاوف بين الدول الكبرى حول إمكانية استخدام هذه التقنية في الأعمال غير القانونية؛ والتي قد تصل إلى العنف. وبالتالي، قرر الاتحاد الأوروبي أن يقود العالم نحو إصدار أول لائحة تنظيمية لعمليات تطوير واستخدام الذكاء الاصطناعي.

اجتمع الاتحاد الأوروبي، المتمثل في 27 دولةً، منذ أسبوع اجتماعًا مطولًا استغرقت الجولة الأولى منه 22 ساعةً بين ممثلي دول الاتحاد، وذلك للتفاوض حول ضرورة إنشاء قانون لتنظيم تقنية الذكاء الاصطناعي داخل أوروبا. وليست هذه المرة الأولى التي يحاول فيها الاتحاد الأوروبي فرض رقابة على الذكاء الاصطناعي؛ إذ يحاول الاتحاد تمرير هذا القانون منذ عام 2019.

ولم يتأثر الاتحاد الأوروبي وحده بهذه المخاوف، إذ ناقشت الدول الكبرى الأخرى مثل الولايات المتحدة، وبريطانيا، والصين ضرورة إصدار قوانين تنظم من عمليات تطوير الذكاء الصناعي، وكان آخرها في قمة الذكاء الاصطناعي التي عُقدت في بريطانيا الشهر الماضي، بقيادة ريشي سوناك رئيس وزراء المملكة المتحدة.

وحضر هذه القمة عددًا من قادة الدول الكبرى الرائدة في هذا المجال مثل وزيري العلوم والتكنولوجيا بالصين والممكلة المتحدة، بالإضافة إلى نائبة رئيس الولايات المتحدة، ووزيرة التجارة الأمريكية. حضر القمة أيضًا قادة أكبر الشركات التقنية الرائدة في مجال الذكاء الاصطناعي مثل سام ألتمان، الرئيس التنفيذي لشركة OpenAI المُطورة لنموذج GPT الشهير؛ وإيلون ماسك، الرئيس التنفيذي لشركات Tesla، وSpaceX، وxAI وصاحب منصة X الشهيرة (تويتر سابقًا).

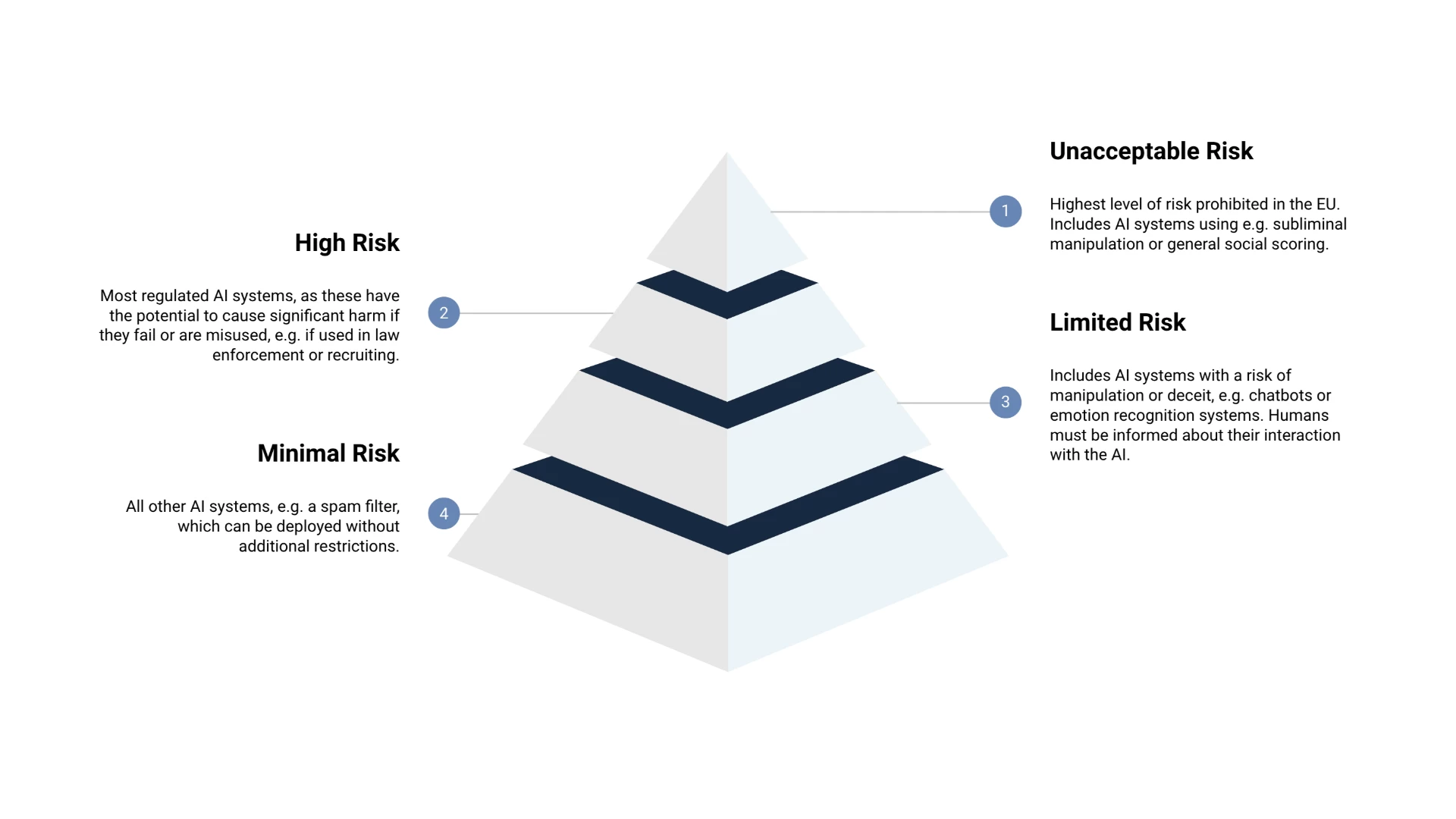

وأخيرًا، وصل قادة الاتحاد الأوروبي إلى اتفاق بشأن إصدار هذا القانون، والذي يُعرف بقانون الذكاء الاصطناعي (AI Act). ومن المتوقع أن يكون هذا القانون معيارًا ومقياسًا لبقية دول العالم المهتمة بإصدار مثل هذه اللائحة التنفيذية. ويعمل هذا القانون من خلال استراتيجية قائمة على تقييم المخاطر وفق مخطط هرمي كالتالي:

- خطر متدني: وذلك في أنظمة الذكاء المستخدمة بألعاب الفيديو على سبيل المثال، ولن تُفرض عليها أي قيود

- خطر محدود: مثل أنظمة المحادثات الشهير كـ ChatGPT، وغيرها، ويفرض القانون على هذه الأنظمة الالتزام بمعايير الشفافية لأقصى درجة خاصةً عند تعامل المستخدمين معها

- خطر مرتفع: وذلك في الأنظمة التي تخترق خصوصية المستخدمين، والتي قد تستخدم في عمليات التوظيف، أو الرعاية الصحية، أو من قبل سلطات إنفاذ القانون، وستخضع هذه الأنظمة بموجب القانون إلى تقييم المطابقة بصورة مستمرة لضمان مطابقتها لقانون الذكاء الاصطناعي.

- خطر غير مقبول: وهي الأنظمة التي يحظرها القانون بشكل كامل نظرًا لخطورتها الشديدة، وهي الأنظمة التي يمكن استخدامها في عمليات الاحتيال والتلاعب بالبشر، أو الأنظمة التي تتعرف على هوية البشر عن بُعد مثل التي تستخدمها الصين في «نظام الرصيد الاجتماعي» الذي يفرض رقابة شاملة على كافة المواطنين باستخدام الذكاء الاصطناعي.

يأتي هذا القانون بالتزامن مع إنشاء تحالف الذكاء الاصطناعي بين IBM، وميتا، بمشاركة أكثر 50 مؤسسة دولية أخرى. ويقوم هذا التحالف على مبدأ تطوير أنظمة الذكاء الاصطناعي بشكل مفتوح المصدر؛ ومع ذلك، نرى أن هذا التحالف يتفق بشكل كبير مع هذا القانون، إذ شدد التحالف على ضرورة وضع لوائح وقوانين تضمن السلامة وتنظم عمليات تطوير واستخدام تقنيات الذكاء الاصطناعي المختلفة.

?xml>